姚星首先回顾腾讯与中国互联网二十年的发展历程,从最初的窄带时代到现在的移动互联网时代,在每一个重要节点腾讯都有一款重量级产品出现。在最近进入到 AI 爆发的阶段,腾讯也顺势成立了自己的 AI Lab。演讲中正式向外公布腾讯 AI Lab 所关注 AI 四个基础研究领域和 4 个专属研究方向。也谈及在趋之若鹜的 AI 浪潮中,大家对人工智能的希望来自于深度学习的算法、模型和数学理论的突破,但同时深度学习自身的能力局限、计算能力的限制以及数学理论的不可解释性为过高的期望降温。

以下为演讲内容整理:

各位朋友大家下午好。今天我演讲的题目——AI:真实的希望与喧哗的隐忧。希望表明了大家对 AI 的期待,而隐忧则说明大家期望过高。

腾讯与中国互联网二十年的发展

回顾中国互联网过去二十年的发展,这二十年是信息高速发展的二十年,大致经历了三个发展阶段:上个世纪九十年代、21 世纪初期以及2010 年后。

在上世纪九十年代初期,中国第一次连上互联网——「跨越长城,连接世界」。随着第一封 e-mail 的发出,中国正式进入到互联网大家庭中来。但是由于当时网络速度的问题,大部分互联网应用只限于沟通。沟通解决了当时的很多问题,人们不再需要面对面才能进行交流,或者通过传统书信的方式进行沟通。不论天涯海角,只要能连上互联网,人们总是可以接触到信息。

随着整个网络设备和传输能力的发展,特别是 2000 年以来,网吧的大量涌现、网络连接速度的大幅提升、网络带宽速度的快速提升,人们对互联网的诉求不再仅仅是消息的传递和沟通,更多的是分享。当时兴起了很多基于分享的应用,博客、MSN、 Facebook、QQ 空间等都是基于分享的。人人为我,我为人人——有很多内容或者信息都是通过互联网来分享的,比如跟朋友分享生活的喜悦和苦恼。

随后移动时代的发展,特别是以智能手机为代表的智能终端的发展,也即自 2010 年以来,移动互联网高速发展所带来明显的变革——人们不再受限于特定时间和特定空间的互联网连接。以前大家都是在网吧或者工作的地方才能获取互联网信息,现在大家随时随地通过智能手机就可以与互联网连接。可以看出,中国互联网过往二十年的发展是随着设备的发展、产业的发展、信息产业的发展而演进的。

伴随着互联网过往二十年的发展,腾讯在过去二十年里做了些什么?实际上在每一个阶段,腾讯都有一款重量级的产品出现。

在上世纪九十年代,也即中国互联网的早期发展阶段——窄带时代,就如刚才所说,当时的互联网主要是用于沟通,在那个阶段腾讯推出了 QQ。QQ 是目前世界上同时在线人数最多的应用,已经达到两亿人同时在线的体量。而到了宽带时代,在 2000 年初的时候,QQ 空间诞生。QQ 空间目前日上传照片数超过五亿张,这个规模跟世界上最大的社交网络 Facebook 相比,几乎是同一个量级,在总照片数量上跟 Facebook 也几乎是同一个量级(2013 年 Facebook 公开数据显示其日上传照片数大概是在 2.5 亿张左右,总照片数大概 6000 亿张)。

然后来到移动互联网时代,为大家所熟知的一个产品就是微信。这款产品不仅是一个简单的应用,WeChat 是一个超级 APP。微信不仅解决了沟通问题,还解决了社交、分享的问题,还支持线下支付、线下打车,甚至医院挂号看病、交水电费等一系列功能都可以在这一个软件上实现。实际上,腾讯的这三款产品在整个世界范围内都是领先的。

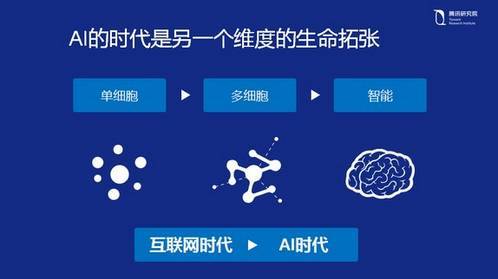

从整个发展史来看,我们可以看出过往的发展史经历窄带时代、宽带时代,然后到现在的移动互联网时代,它犹如生物进化一般,从原始的单细胞生物到多细胞生物到最后有智能的生物。那么今年来讲「智能」,智能会更加的广义,不仅仅是智能终端,大家讨论更多的智能是 AI。

腾讯的 AI 布局

2016 年正好是 AI 发展六十周年,从去年开始 AI 迅速爆发,可以说是家喻户晓。这也是为什么我刚刚在跟很多嘉宾聊的时候说,大家觉得腾讯在 AI 上很低调,没有什么大动作。甚至有很多人问我腾讯到底有没有在做 AI?怎么从来没有向外界宣布任何 AI 相关的布局规划呢?实际上腾讯有自己的 AI 部门,从 2016 年 4 月份开始,腾讯成立了自己的 AI Lab,目前已经有 30 多位的 Research Scientists,绝大多数拥有博士学历及以上且都有海外研究经历。他们中业界的来自于微软、IBM、Facebook 等公司,学术界是从世界最顶级学府引进的人才,包括斯坦福、加州伯克利、康奈尔、麻省理工、哥伦比亚大学等顶级高校。

目前在腾讯,我们已经组织了一个 30 人左右的 AI Lab,而且规模还在扩张。腾讯的 AI 可能不像其它公司的 AI 为人所了解,比如说谷歌的 AI,很多人都知道 DeepMind 在做围棋,他们用强化学习来实现,而且他们用强化学习来完成很多任务。以及他们提出了很多的神经网络结构(neural network),比如 WaveNet,deepNet,LipNet 等;而百度为大家所熟知的有无人车、度秘等一些产品。但腾讯的 AI 一直没有对外宣传,今天我也跟大家分享腾讯在 AI 上面的一些考虑。

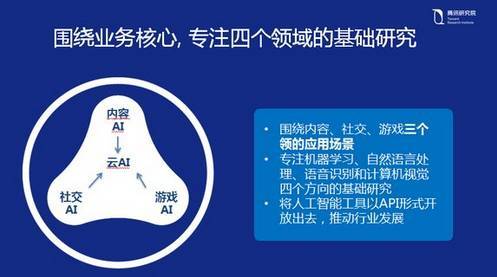

实际上腾讯的 AI 主要基于四个垂直领域,计算机视觉(Computer Vision)、语音识别(Speech Recognition)、自然语言处理(NLP)和机器学习(Machine Learning),每一个领域都是代表了 AI 的一个基础的研究方向,但是每个领域都可以更多深层次的研究拓展。比如在计算机视觉领域,除了传统的图像处理还会有增强现实(AR)的研究拓展,也会引入空间定位(Simultaneous Localization and Mapping)技术;比如在语音识别领域,我们除了传统的语音识别、语音合成以外,还会引入更多的跟语音相关的拓展研究比如说自动翻译(Translation)。另外在 NLP 里,除了传统的自然语言处理的对人的认知行为的一些研究,我们还会做聊天机器人的一些研究。在 ML 里,从监督类的机器学习到无监督的机器学习,然后到增强学习的机器学习,都会展开相关的研究。这四个领域基本上涵盖了当今整个 AI 基础研究领域的方方面面,也是腾讯 AI Lab 将会关注的四个基础研究领域。

然后我们还提出了四个专属的研究方向,这是结合整个腾讯公司的业务来进行的。

我们提出了内容 AI(Content AI),我们把基于内容类的推荐和搜索类的应用都归属在内容 AI 里。

另外还有我们的社交 AI(Social AI),腾讯是一个社交应用上很强势的公司,包括刚刚说的 QQ 空间、微信都是社交平台,所以在社交 AI 上面我们会基于社交考虑来研究相关的 AI 技术,比如社交中的对话、聊天机器人、智能助手等,都会纳入这个研究方向中来。

另外一个方向,我认为是和全世界其他所有的公司都不太一样的一个 AI 方向,即我们的游戏 AI(Game AI)。大家可能会问我,DeepMind 也有做围棋的 AI,但是它只是一个围棋游戏,它不会涉及到太多的游戏。而对于腾讯来讲,在整个腾讯集团里面,游戏是腾讯一块很大的业务。我们会在游戏里面引入更多 AI 能力,实际上这个 AI 游戏的想像空间是非常大的。大家试想一下,会不会有一天 LOL 里 AI 也来参加世界电竞赛,与人类交战。大家知道现在腾讯有一款很受欢迎的手游叫做「王者荣耀」,如果把这里面的能力提升,是不是可玩性、乐趣性就会更多,腾讯对这一块也是很关注的。

除此之外我们还会提供很多工具类的 AI,会结合到腾讯的云服务,我们需要研发相关技术从而加强相关能力来实现这些工具的开放。这些工具将包括基于图像的人脸识别的能力、语音识别的能力、在自然语言处理里的舆情处理能力等,还包括我们在深度学习上的开放深度学习平台的能力。

所以说从目前来讲,整个腾讯 AI 研究的基础领域是四个,我们的专属研究方向也是四个。

深度学习喧嚣之下的隐忧

AI 不是一个新的概念,它的发展经历了六十多年,在这六十年里,人工智能的发展之路并不平坦。在去年人工智能又突然爆发了,势头一直延续到了现在。1956 年的达特茅斯会议,AI 这个名词被首次提出。人工智能比较有名的事件是九十年代 IBM 深蓝打败了卡斯帕罗夫,也就是那个时代的 AlphaGo 和李世乭。人们记忆中最清晰的一件事还是去年 AlphaGo 围棋打败围棋世界冠军李世乭,这表明在围棋这个最古老、最复杂的游戏上面,AlphaGo 的智能已经超越了人类。

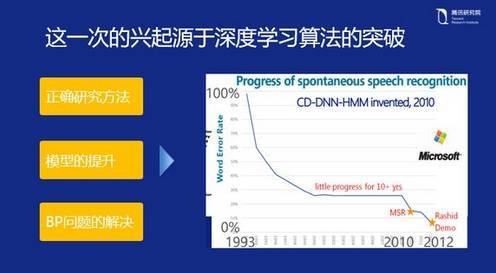

当然整个发展史里面也有很多技术方面的演进,比较有代表性的就是 2006 年,Geoffery Hinton 在深度学习上有了巨大的突破,带领 AI 的所有发展方向极速提升。我认为这次人们期待 AI 最主要的原因是这一次 AI 的底层算法在深度学习上面有了实质性的突破。

这次 AI 的发展是从 2012 年开始的,先在业界落地。可以看到整个深度学习的方法和传统方法完全不一样,不像以前的研究方法,是通过模仿来实现的。这一情形和早期人类想粘上羽毛学习飞翔比较类似,我们都知道真正的飞翔是通过空气动力学去完成的,这也是深度学习的一个思想之一。之所以现在能有很多应用上的突破,是因为研究员们掌握了内在的学习方法,而不是表面的模仿。所以从这一点来说,我们现在在深度学习的研究方法上是正确的。

第二个是模型上的提升,刚才我说了,AI 的发展有六十年,机器学习以及深度学习并不是最近才突然出现的。神经网络早在六十年代就有过——当时提出来感知机(perceptron)。机器学习在八九十年代也非常火,当时有一个叫 SVM(支持向量机)的分类器,已经是非常厉害的一种机器学习的算法。那么现在为什么又重新提出来?深度学习同原来的机器学习相比,在模型能力上有非常大的提升。大家都知道我们所有的机器学习的方法,都是从 A 到 B 去寻找一个拟合函数,实现一个最佳的拟合过程。在这个过程中如果选取的特征越多,拟合的效果就会越好。但同时有一个问题,当特征太多的时候,计算能力就会出现问题。在浅层模型中,如果要模拟出一个从 A 到 B 的完美拟合过程,它的数据能达到几亿甚至几十亿的规模,当他达到这种规模的时候它的计算能力就会急剧下降,会通过一个非常复杂的复合函数去描述数据。但是深度学习的方式能够很好的解决这个问题,它通过深度学习神经网络的多层连接,其特征表达是一个指数层倍的关系,如果说用一个全连接(fully connected)描述十亿的特征,可能我们只需要三层一千个节点的连接,就能构建十亿个特征的权重出来。所以从本质来讲,模型上的提升也是深度学习的一个突破。

另外,针对反向传播问题(BP),AI 界从 80 年代开始真正使用 BP 算法来训练多层神经网络。在神经网络里,当输入信息由多层网络向前传播之后,将网络的输出结果与实际结果的误差,从输出层向输入层反向传播。在整个 BP 过程,都是需要通过随机梯度下降的方式进行求解,以逐渐逼近最优值。今年来,随着网络结构的不断加深,使用传统的 Sigmoid 激活函数使深层网络的参数优化过程中出现梯度消失的问题。通过一些数学的理论和技巧,可以很好解决这种梯度消失问题,以用于训练非常深层的神经网络。

正因为这三方面的优势,使得在这次 AI 的浪潮里,深度学习才会如此之火。而且我坚信这次的 AI 浪潮会持续很久。在 1993 年到 2000 年左右,整个传统的浅层机器学习的研究进展还是很不错的,图中可以看到这段时期错误率有明显的下降,也即识别效果的提升很快。但是从 2000 年到 2010 年这十年,可以看出没有明显的下降变化。可能是在方法上面,在模型上面都没有太大的研究进展。在 2012 年左右有一个明显的转折点,也就是微软研究院第一个在业界把深度学习用于语音识别,取得了极大性的突破,随后又进行了一系列性能上的提升。在过往的五年当中,深度学习的发展是非常快的。

讲了很多深度学习的内容,刚才谈到深度学习的快速发展,它的方法很好,模型也很好,数学算法也在突破,但是现状是什么呢?今天我想谈的话题是大家对 AI 的期待很大,但期待有些过,为什么会这么讲?作为一个从业者,我认为目前 AI 上还是有很多局限的,可能需要提出来,与大家一起探讨。

第一个是深度学习本身所具备的能力,即大家所说的将 AI 与人类相比,存在多大的差距。实际上如今所有的深度学习方法,不论这个方法有多么的新,其学习过程都是要从头开始,需要经历数据重新训练的过程。这一点和人的学习能力相比确实有很大的差距,因为人有很多的智能是与生俱来的,如小孩刚出生,他感知这个世界是三维的并不需要多长时间,并且如果你将一个物体放在电视机后面,他会知道电视机后面有这样一个物体,这些能力是与生俱来的,其与生物的进化是相关的。所以灵长类动物和单细胞生物相比是有与生俱来的能力的,人类的小孩不需要再次经历单细胞演进到灵长类动物这一过程。但在目前的深度学习方法下,不论我们提出了多么优秀的模型,其都需要从最开始的数据开始学。这和人类的学习能力相比,是一个巨大的缺陷。

第二个是计算能力。不论是多么好的深度学习模型或者神经网络出现,本质上还是通过计算能力去解决大数据的问题,更好的计算能力去做更好的拟合。在这个计算力上面,过往的十年是整个硬件发展的十年,是符合摩尔定律的。但是在以后需要训练更多参数的情况下,我们能否有足够的计算力以达到预期效果还有待商榷。

从 2012 年提出来的 AlexNet 网络模型,这个模型在当时的 ImageNet 挑战赛中获得冠军,到剑桥大学提出的 VGGNet,谷歌提出的 GoogleNet,再到 2015 年 MSR 提出的残差神经网络 ResNet,每一次新模型的提出都伴随着模型层级的增加、神经单元复杂度的加强、训练过程的加长,当然得出来的结果也更好。但是这种通过计算力去解决问题的方式是不是还能像以前一样可持续,有待商榷。

刚才所说的都是图像方面的研究,谈及人工智能来解决系统认知问题,那么与人的差距就更大了。人类语言是一个序列问题,这个语言序列问题如果通过神经网络去训练的话,仅通过计算力是不可能解决这个问题的。人在对话当中很容易回溯到长时间语句的某个片段关键词里。但在机器学习中却不一定能做到这样,虽然从最早的 RNN 模型中构建了 LSTM(长短期记忆单元)模式,后来又提出了带注意力的模型。但总体上,这种模型的演进和人类相比是远不如人类的。举个自然语言处理(NLP)的例子,有三个人在对话,两个人在聊湖人跟快船的比分是几比几,然后中间有大段话题转到去哪里吃饭,突然插进来第三个人问太阳呢?机器这时候很难理解「太阳」到底是哪个太阳,聊天者知道这是描述太阳队,因为在「去哪吃饭」这个话题前有湖人和快船的话题。但是机器基本上没办法识别,又如「夏天能穿多少穿多少,冬天能穿多少穿多少」,这两句基本一样,但前面的描述突出少,后面的突出多。这种认知行为到目前为止,深度学习上再先进的方法也没办法处理。

第二个例子是语音识别,我看过一个笑话,语音识别很难处理,「您好,方便面试吗?」我在重复这句话的时候,我都不知道自己在讲方便面——是吗,还是方便——面试吗,这的确是一个非常难的问题。但是人的理念里有很多东西,是可以通过反问,多次获取信息来最终理解。所以说目前人工智能情况,在图像方面,例如人脸识别的精确率有多么高能达到 99% 的识别率,但实际上是在很多的约束条件下才能实现,识别正脸的模型不能识别侧脸,或者是把同一个人的侧脸完全识别成另外一个人。在语音识别里也是如此,目前语音识别是在获取的信息源很干净的情况下才能有很好的效果,比如噪音比较小、没有混响、没有风噪和车噪,在这样的条件下,机器在听语音识别的时候才可能会识别出比较好的效果。但对人来说,这完全不是问题,以及多人的面部识别,语音跟踪,这些对人来说都不是很难。但是对机器而言,即便在我刚刚所说的感知领域——图像识别和语音识别,它跟人基本的能力相比还有很大差距,更别提在认知的任务处理上,比如 NLP 的语意理解。

对于整个人工智能领域来说,我认为人们现在对 AI 的期待过高。我们要回归现实,AI 现在方兴未艾,这个趋势是很好。但未来 AI 发展的方向是什么呢?我觉得 AI 跟人,也即深度学习跟人的能力相比还是有些差距的。

跟人相比第一个是创造力的不足。我们现在所有深度学习的模型都是基于大数据的,这些数据从何而来?目前的数据还是通过传统的方法获取到的,但能不能通过深度学习本身创造出更多的数据?AlphaGo 已经在验证这样的问题,通过增强学习产生了人类从未下过的棋局并以此来训练模型,这是一种创造数据的能力。我觉得未来在这方面发展,在增强学习上,我们要进行更多的发展和突破。

第二个是举一反三能力。AlphaGo 下围棋能赢世界冠军,但是它如果改下其他的棋,它的下棋方法就不行了,因为它的算法只是为围棋而设。人的很多能力是可以举一反三的,比如小孩做数学题,当他学会列二元一次方程之后,他会很快掌握二元一次方程的技巧去解决这一类的数学应用。这种能力在机器学习里面也有一个同质的算法——迁移学习。当我们在一个全新的应用场景里,在少量数据的情况下去测试一个在大数据集上表现非常好的模型,如何把原来的模型迁移过来并且能够应用在新场景里,这是一个非常重要的研究方向。

第三是归纳总结的能力。人的总结能力是很强的,比如牛顿第一定律、万有引力定律等,都是总结出来的,还有很多公理也都是归纳总结出来的。但是目前机器学习是没办法进行归纳总结的,机器学习的结果再好也只是一个拟合过程,并没有能力去归纳提炼。未来我们要在模型归纳总结能力上提高,如何从海量的结构化或者非结构化的数据中,通过机器学习来完成知识的总结和提炼神经网络中的知识(distill knowledge)。

这三个能力,我认为这是未来 AI 需要进行提升的地方。

另外一个维度的缺陷是在数学理论的发展方向上,刚刚讲过的很多机器学习适用的数学原理和方法,实际上是很脆弱的。跟过往浅层学习的数学理论相比,深度学习的数学原理还有很多不可解释。在浅层学习里,有完备的统计学概率论理论提供支撑。比如求解凸函数的极值,有很多完善的数学理论能够证明有最优解的存在。但是在深度机器学习的研究中,虽然前面有提到可以用随机梯度下降的方法去求解局部最优值,但是它只是一个框架。我们在很多方面还在使用启发式的约束,比如初始化参数的设置、激活函数的设置、学习率是多少,这都是基于启发式的,也即依赖于人的经验。未来机器学习的继续发展,在数学理论上面一定要有强大的支撑。此外,在交叉学科的研究上要继续加强,我们知道感知机以及神经网络的提出来源于脑神经学科,未来 AI 发展肯定要引入更多学科,不仅是统计学科、数学学科、计算机学科,还要引入脑神经学科。之前所提到的残差神经网络,这个网络在设计上已经有一点接近脑神经的设计了。因此,未来 AI 能有更完备的发展,是需要将这些学科的研究都综合起来的。

再有一点,就是 AI 研究的开放与平等。我认为对任何公司和任何人,AI 都应该是平等的,这也是我们要做开放 AI 的立足点之一。在现在的 AI 领域里,所有的大公司都在做开源,腾讯当然会开放自己的研究。各大公司在开源上都表现出很积极的一面,比如谷歌开源了自己的机器学习框架 TensorFlow,还有很多机器学习的先行者(DeepMind、OpenAI)在做开源,在开放开发框架和训练数据。腾讯未来也会进行开源很多内容,提供一个让更多人参的平台,共同开发人工智能。

对于未来 AI 技术的发展,首先是能力的提升,在创造能力、举一反三能力以及归纳总结能力上有长足进步;另一方面是机器学习的完备性,我们要在数学完备、学科完备上进一步进行探索;同时,所有的科技公司,AI 的参与者都要以更加开放的心态去面对人工智能。

未来 AI 大有可为

说到这个话题,我又想再次强调 AI 对腾讯来说是非常重要的,对整个中国互联网都很重要。回顾整个互联网浪潮,在互联网时代的初始阶段,中国的互联网公司跟美国最强的互联网公司相比有一定的差距。而当下的 AI 时代,我坚信中国的互联网公司跟世界上一流的公司是处于同一位置的,为什么?第一点原因,我们数据足够多,中国的互联网人数是世界上其他国家的互联网人数的总和。在腾讯的业务里面,微信、QQ、QQ 空间,已经产生了海量数据。在中国的其他互联网公司,比如电商和搜索的公司也会产生大量数据,这些对中国公司来说,是一个非常好的优势。第二个原因是来自应用场景,对于腾讯的业务来说,我们有很多种把 AI 这种听起来似乎遥不可及的技术在微信、游戏、新闻、QQ 里通过 AI 产品去落地,哪怕只是一个小点上的应用。第三点是人才,目前的数据表明从事深度学习的研究人员中相当一部分人都是中国人。虽然国内在机器学习上的专业还比较少、学科也比较少,但是在全球范围内,研究深度学习和机器学习的华人是非常多的。我参加 16 年的 ICML 和 NIPS,ICML 有 3000 多人,NIPS 有 6000 多人,有 30-40% 的参会人员都是华人,40% 的会议 paper 都是华裔写的,在人才结构上,中国有很好的人才基础。正是基于我们数据的优势,场景落地的优势,人才结构的优势,我觉得腾讯以及其他中国互联网公司,未来在 AI 上大有可为。

最后,腾讯的 AI 使命: Make AI Everywhere——让 AI 无所不在。

为您推荐

中国加快推进"三网融合"的决定将最先惠及从事光缆、光纤和机顶盒等相关设备制造商,但长远看来,那些拥有多样化内容、创新服务以及广泛传播渠道的综合性公司才会是最大受益者."三网融合"并非将电信网、互联网和广播电视网进行简单的物理整合,更为重要的是业务应用的融合.在”三网融合"的情景下,用户通过一张网络就可以完成打电话、上网和看电视等需求.中国国务院近日决定拟于2010-2012年重点开展广电和电信业务双向进入试点,在2013-2015年全面实现三网融合发展.今後,符合条件的广播电视企业可以经营增值电信业务和部分基础电信业务、互联网业务;符合条件的电信企业可以从事部分广播电视节目生产制作和传输.美国

上次提到,中国加快推进“三网融合”,从宏观层面分析,将有助拉动内地中长期的经济发展;从微观层面分析,将率先惠及从事光缆、光纤和机顶盒等相关设备的制造商,而长远看来,那些拥有多样化内容、创新服务,以及广泛传播渠道的综合性企业将会是最大得益者。高盛的一份研究报告就估计,未来几年,电信公司和有线电视公司将增加资本支出以升级网络,而新的投资将会引入新的服务,这将从整体上增加广播电视和电信业的收入。该报告又指出,虽然目前“三网融合”仍未对电信公司的股价有任何刺激作用,至于有线电视类股份的强势,则有点来得过早的感觉。不过,综合来说,“三网融合”未来将可造就几家综合性“航母级”企业,其中两只是在港上市的中移

从湖南广播电视总台获悉,在深圳第六届文博会举行期间,湖南广播电视总台台长欧阳常林与腾讯公司董事局主席兼CEO马化腾现场签订《战略合作框架协议》,双方将共同投资2.2亿元人民币合作“交互传媒”项目,联手拓展电视和因特网融合交互的内容产品,建设跨媒体的交互传媒平台。总投资2.2亿元据了解,芒果传媒是运营湖南广播电视台所有经营性资产的产业主体,在艺员经纪、新媒体、卡通动漫等业务见长。腾讯为中国服务客户最多的因特网企业,其业务覆盖中国90%以上网民。在双方合作框架中,芒果传媒将注入其优势业务,与腾讯的海量客户资源进行集成。同时,腾讯旗下交互娱乐产品、移动因特网服务及门户网站等优势因特网业务都将接入合作